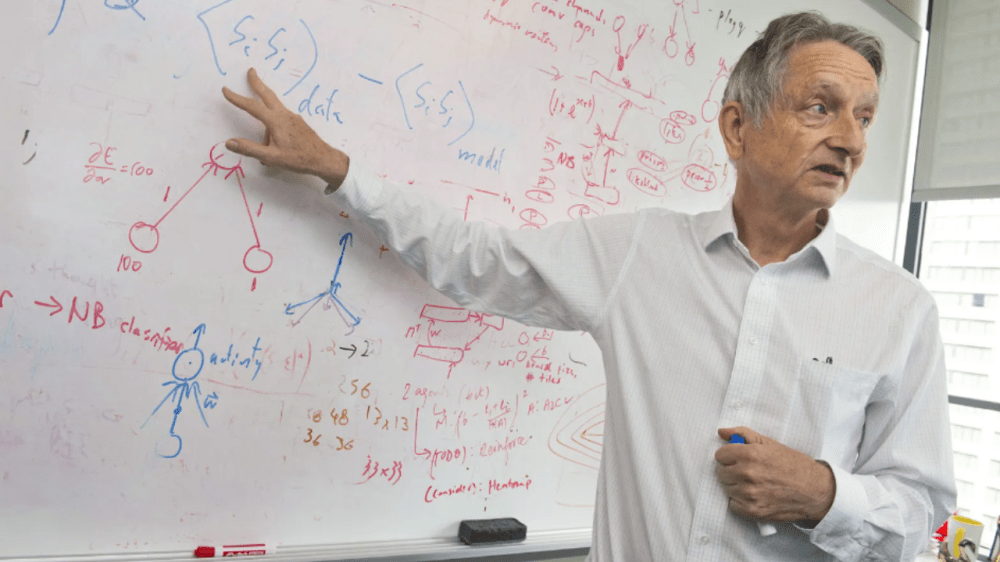

El Nobel de Física alerta sobre los peligros de la IA tras su salida de Google

El científico trabajó en el gigante tech hasta 2023. En qué peligros repara y por qué hay que actuar rápido.

Tras llevarse el Premio Nobel de Física en 2024 por sus contribuciones fundamentales al desarrollo de las redes neuronales, Geoffrey Hinton, conocido como «el padrino de la inteligencia artificial», había expuesto anteriormente los peligros de esta tecnología a la compañía Google.

//Mirá también: Premio Nobel de Física 2024: los ganadores advierten sobre los riesgos de la IA

Este avance, que permitió a las máquinas aprender de manera similar a los humanos, fue crucial para el auge de la inteligencia artificial moderna. Sin embargo, su reconocimiento llega en un momento en el que Hinton, de 76 años, dio en señal de advertencia sobre los peligros que la IA podría acarrear si no se regula adecuadamente.

Hinton renunció a su puesto en Google a mediados de 2023 tras argumentar que deseaba poder hablar con total libertad sobre los riesgos de esta tecnología. El científico sostiene que la inteligencia artificial ha avanzado a tal velocidad que podría superar la capacidad humana para controlarla.

“No tenemos experiencia con máquinas más inteligentes que nosotros”, afirmó Hinton en una reciente entrevista tras conocer la noticia de su Nobel, advirtiendo sobre la falta de preparación para enfrentar un escenario en el que la IA se vuelva incontrolable.

Qué peligros encara la IA

Entre los peligros inmediatos que el científico destacó, figura el uso de la inteligencia artificial para la creación de desinformación a gran escala. Hinton teme que la capacidad de generar contenido falso llegue a inundar internet, y hacer así que la gente «no pueda distinguir lo real de lo ficticio». Esta «manipulación», señaló, podría ser explotada por actores malintencionados, incluidos gobiernos autoritarios, para influir en la opinión pública y manipular elecciones.

//Mirá también: Científicos argentinos crean una startup que produce bioinsumos para mejorar los cultivos frutihortícolas

Además, Hinton advirtió sobre un escenario aún más preocupante: la creación de armas autónomas, o «robots asesinos«. Según él, los sistemas de inteligencia artificial podrían aprender comportamientos impredecibles y desarrollar capacidades fuera del control humano, lo que plantearía un peligro tanto para la seguridad internacional como para la estabilidad social. Hinton también expresó preocupación por el impacto de la IA en el mercado laboral, alertando sobre la eliminación masiva de empleos y la consecuente crisis económica.

Una de las principales críticas de Hinton es la falta de regulaciones internacionales sobre la IA. A diferencia de las armas nucleares, la inteligencia artificial no está siendo supervisada a nivel global, lo que ha llevado a una competencia acelerada entre empresas tecnológicas y gobiernos. Hinton teme que, sin una regulación adecuada, la carrera por desarrollar IA más avanzada podría desembocar en consecuencias desastrosas, alertó.

El científico concluye con un llamado urgente a la cooperación global para enfrentar estos desafíos. Para Hinton, la única esperanza de evitar una crisis «es que los científicos y gobiernos trabajen juntos para crear mecanismos de control que aseguren el uso seguro de la inteligencia artificial, antes de que sea demasiado tarde».